Inleiding

Robots doen het goed in de media. Ministers spreken zich uit over de mogelijke effecten die robots in de toekomst kunnen hebben voor de economie. Televisieprogramma’s behandelen de vooruitgang in de robotica, zoals onlangs in de VPRO-programma’s Tegenlicht en De Volmaakte Mens. Amusementsseries zoals Real Humans laten zien hoe een samenleving waarin robots een belangrijke rol spelen eruit zou kunnen zien. En uiteraard het internet biedt een scala aan berichten en meningen over robots en hun effecten op de toekomst van de maatschappij. Een opvallend kenmerk van veel berichten is de dreiging die blijkbaar van robots uitgaat, variërend van verlies aan werkgelegenheid tot een bedreiging voor de mensheid zelf zoals in de film I Robot.

Het idee dat robots een bedreiging kunnen vormen staat niet op zich. Het is een onderdeel van een gevoel van onbehagen over de ontwikkelingen van Artificiële Intelligentie (AI). Mensen als de bekende fysicus Stephen Hawking hebben reeds gewaarschuwd over de mogelijke gevolgen van de verdere ontwikkeling van de AI. Naast positieve effecten voor de maatschappij kan AI ook een gevaar inhouden. Vooral als de ontwikkeling van AI autonoom wordt. Dit zou kunnen gebeuren als AI-systemen zichzelf gaan ontwikkelen, zonder tussenkomst en controle van mensen, zoals voorspeld door Kurzweil (2005)10. We zouden dan in een situatie terecht kunnen komen waarin AI-systemen te intelligent zijn om nog door de mens begrepen, laat staan gecontroleerd te worden (Bostrom, 2014)3.

De relatie met robots is dan gemakkelijk gelegd. Robots zijn immers voor hun gedrag afhankelijk van AI. In feite is een robot een AI-systeem dat zelf handelingen kan uitvoeren. Dus als AI een gevaar zou kunnen vormen dan geldt dat voor robots al helemaal, omdat zij hun intelligentie kunnen aanwenden voor vormen van kwaadaardig gedrag.

Ontwikkeling van AI

Het is zonder meer waar dat de ontwikkelingen in de AI en robotica snel gaan. Een mooi voorbeeld is de computer Watson van ibm. Deze computer is de opvolger van Deep Blue die de toenmalige wereldkampioen schaken Gary Kasparov heeft verslagen. Een computer die de mens verslaat in een intelligent spel als schaken is al heel wat. Maar Watson overtreft dit nog; Watson heeft het spel Jeopardy gewonnen in een spel over drie ronden (in drie dagen) van de twee beste spelers van de laatste tien jaar.

In Jeopardy (‘gevaar’ of ‘risico’) wordt een aanwijzing gegeven in de vorm van een antwoord. Spelers moeten dan bepalen wat de vraag is die bij dat antwoord hoort; zij geven hun antwoord dus in de vorm van een vraag. De aanwijzing kan bijvoorbeeld luiden: ‘Een vliegveld ten zuiden van Amsterdam’. Het antwoord is dan de vraag ‘Wat is Schiphol?’ De aanwijzingen die spelers krijgen, horen bij een bepaalde categorie die zij kunnen kiezen. Bij elke aanwijzing hoort een geldbedrag. Geeft de speler het goede antwoord (dus stelt hij de goede vraag), dan krijgt hij het geld; is het antwoord (de vraag) verkeerd, dan verliest de speler dat geld – vandaar de naam van het spel. Dit maakt dat spelers behoorlijk zeker moeten zijn van hun reactie voordat ze op de knop drukken. Tegelijk moeten ze dat zo snel mogelijk doen, om hun tegenspelers voor te zijn.

Wat het winnen van Jeopardy bijzonder maakt is niet eens zozeer het benodigde niveau van intelligentie; misschien moet je zelfs intelligenter zijn om de wereldkampioen schaken te verslaan. Maar Jeopardy is bijzonder omdat elk willekeurig onderwerp aan bod kan komen. Je moet dus beschikken over kennis van een groot aantal onderwerpen. Bovendien moet je dan zo snel mogelijk kunnen reageren. Bij schaken kan een computer de regels, voorbeelden en zoekstrategieën leren. Door zijn omvangrijke geheugen kan de computer die dan toepassen in zeer veel verschillende schaakstellingen. Maar bij een spel als Jeopardy zijn de regels en zoekstrategieën veel minder duidelijk.

De vooruitgang die Watson heeft bereikt, is dat hij nu gewone teksten kan analyseren en snel een aantal mogelijke antwoorden kan formuleren. Watson kan dan ook inschatten wat de betrouwbaarheid van die antwoorden is. Bovendien kan hij leren. Zijn kennis neemt toe, niet alleen omdat hij meer teksten kan doorzoeken, maar ook omdat hij leert van zijn fouten. Dit lijk wel heel erg op wat wij mensen doen. Wij lezen immers ook teksten en proberen daaruit kennis te halen die we ergens kunnen toepassen.

Watson leert omdat hij de antwoorden die hij geeft op vragen kan aanpassen als blijkt dat hij een fout maakt. Hij doet dat door een andere afweging te maken tussen de verschillende programma’s die hij gebruikt bij het genereren van een antwoord. Watson is een computer met duizenden processoren die voor een groot gedeelte parallel werken. Elke processor berekent, simpel gezegd, een antwoord op basis van een bepaald programma (bijvoorbeeld: zoeken naar de meest vaak voorkomende combinatie van woorden in een tekst). Alle antwoorden tezamen worden dan gewogen, en de combinatie resulteert in het uiteindelijke antwoord. De factoren waarmee Watson de verschillende antwoorden (en dus programma’s) weegt, kunnen bij het maken van verkeerde antwoorden worden veranderd, net zo lang tot een goed antwoord ontstaat. Zo leert Watson hoe hij zijn verschillende processoren (programma’s) het beste kan gebruiken, en welk programma in welke situatie het meest betrouwbaar is.

Met het leervermogen van Watson is een relatie gelegd tussen Watson en ‘gewone’ intelligentie, en wordt het verontrustend dat een computer ons op dit punt ook al de baas is. Nu zijn de handelingen die Watson kan uitvoeren nog beperkt. Maar als Watson het brein wordt van een robot, zou de mogelijke overheersing van mensen door robots een stuk dichterbij kunnen komen.

Watson als robot

Je zou inderdaad een robot kunnen laten aansturen door een computer als Watson. Maar dan moet er nog veel gebeuren aan AI om dat te kunnen uitvoeren. Watson kan inderdaad teksten analyseren, zo goed zelfs dat hij nu wordt ingezet bij het opstellen van medische diagnoses. Maar Watson kan bijvoorbeeld niet zien of horen, evenmin kan hij bewegen. Dat laatste op twee manieren niet. Allereerst is Watson een supercomputer die met gemak een zaal vult, en de energie die hij gebruikt vergt een kleine energiecentrale. Het valt niet mee om dat alles in beweging te krijgen. Bovendien heeft Watson niet geleerd om te bewegen of een robot aan te sturen.

Nu zijn computers de laatste decennia wel steeds kleiner en sneller geworden. De regelmaat waarmee dit is gebeurd, staat bekend als de wet van Moore – genoemd naar een van de oprichters van chipfabrikant Intel die deze ontwikkeling in de jaren zestig van de vorige eeuw heeft voorspeld. De wet van Moore speelt ook een belangrijke rol in het idee dat robots ons in de toekomst zouden kunnen bedreigen. Immers, als over een aantal jaren kleine computers net zo krachtig worden als Watson nu, dan kan een robot gemakkelijk met een dergelijke computer worden uitgerust en wordt zijn intelligentie ons wellicht de baas.

Maar juist de wet van Moore laat zien hoe lastig het is om een trend uit het verleden onbeperkt door te trekken naar de toekomst. Er zijn fysieke grenzen aan de verdere verkleining van de computerchips. Het is dus helemaal niet zo zeker of een computer als Watson in de toekomst in een laptop past; het lijkt er eerder op dat dit niet zal gebeuren. Daarmee zou een robot met een supercomputer verbonden moeten zijn om de rekenkracht van Watson te hebben. Bedenk hierbij dat Watson werkt met duizenden parallel opererende processoren en dat ieder van die processoren toegang wil hebben tot de robot. Een internetverbinding tussen de robot en de computer raakt dus al snel overbelast. Daarmee wordt het moeilijk voor een supercomputer om van afstand een robot doelgericht te kunnen laten bewegen in allerlei, niet van te voren programmeerbare omstandigheden

Grounded cognitie

Er is een tweede reden waarom Watson niet het model is van het brein van een robot. Watson is zeer goed in het analyseren van teksten, dankzij het feit dat juist tekstuele informatie goed in digitale vorm te vatten en dus ook te analyseren is. Dit sluit aan bij de language-of-thought-hypothese van cognitie zoals door Fodor (1975)6 en Pylyshyn (1984)12 geformuleerd. In deze visie heeft cognitie een talig karakter. Perceptie verschaft informatie over de buitenwereld. Deze informatie wordt in het cognitieve systeem omgezet in symbolische vorm. Complexere informatie bestaat dan uit talige structuren die zijn opgebouwd uit deze symbolen. Het verwerken van de informatie en het genereren van gedrag komt voort uit het verwerken van deze talige informatie, op een manier die analoog is aan het verwerken van echte (natuurlijke) taal.

Sinds de jaren tachtig van de vorige eeuw staat deze visie over cognitie steeds meer onder druk. Bijvoorbeeld: een probleem bij deze visie is de betekenis van de symbolen in een cognitief systeem. Wanneer hebben symbolen betekenis voor een cognitief systeem zelf? Searle (1980)13 heeft dat vergeleken met het voorbeeld van een Chinese kamer. In deze kamer zit een persoon die Chinese symbolen ontvangt en analyseert aan de hand van een woordenboek. Op basis van de regels in het woordenboek kan hij dan weer nieuwe symbolen als antwoord genereren. De vraag blijft echter of deze persoon (of het gehele systeem) daadwerkelijk Chinees begrijpt.

Harnad (1991)8 formuleerde een antwoord op dit probleem. Hij stelde dat symbolen alléén inderdaad geen betekenis hebben voor het systeem, ook al omdat ze willekeurig gekozen kunnen worden. Om betekenis te krijgen, moeten symbolen ‘gegrond’ (grounded) zijn in de perceptie-actiecyclus van het systeem. Doordat het systeem waarneemt en waarnemingen kan koppelen aan acties, ontstaat in het systeem de mogelijkheid om symbolen te koppelen aan percepties en acties. Daarmee krijgen de symbolen betekenis voor het systeem.

Het is interessant op te merken dat dit inzicht nauw aansluit bij de ideeën van Donald Hebb9 over de relatie tussen brein en cognitie. In 1949 (dus in de hoogtijdagen van het behaviorisme) publiceerde Hebb zijn boek The Organization of Behavior. Daarin analyseerde hij de vraag hoe cognitieve processen kunnen ontstaan in het brein. Als antwoord formuleerde hij drie basisprincipes van de relatie tussen brein en cognitie. Het eerste principe staat bekend als de Hebb-regel. Die stelt kortweg dat de verbinding (synaps) tussen twee neuronen wordt versterkt als beide neuronen gelijktijdig actief zijn. Dit geeft een basisprincipe van leren. Immers, tijdens een bepaalde waarneming of actie zullen bepaalde neuronen actief zijn. Door hun verbinding te versterken, zal de waarneming of actie in het geheugen worden opgeslagen.

Het tweede principe van Hebb sluit hierop aan. Dat stelt dat door de werking van de Hebb-regel er in de loop van de tijd specifieke structuren in het brein ontstaan die bestaan uit neuronen die sterk met elkaar verbonden zijn. Hebb noemde een dergelijke structuur een cell assembly. Een voorbeeld van een cell assembly zijn de neuronen in het brein die geactiveerd worden bij het zien of horen van een hond. Hierbij zijn neuronen betrokken in de visuele cortex die reageren op het beeld van een hond, en neuronen in de auditieve cortex die geactiveerd worden door het geblaf van een hond. Omdat deze neuronen vaak tegelijk geactiveerd worden als we een hond tegenkomen, zullen ze volgens Hebb onderling met elkaar verbonden raken. Later komen daar nog andere neuronen bij, zoals neuronen die het woord ‘hond’ verwerken of neuronen die geactiveerd worden bij het aaien van een hond. Samen vormen deze neuronen de cell assembly die de ervaringen vastleggen die wij met een hond (of honden in het algemeen) hebben.

Het derde principe van Hebb geeft het belang weer van cell assemblies voor cognitie. Hebb stelde dat cognitieve processen zoals ‘denken’, zullen bestaan uit het selectief activeren van sequenties van cell assemblies. Hebb vergeleek het selectieproces dat hierbij optreedt met het proces van aandacht. Een voorbeeld van een sequentie van cell assemblies in cognitie is een structuur van een zin zoals die gevormd kan worden in het brein. Het is inderdaad mogelijk zinsstructuren in het brein te beschrijven in termen van ketens van cell assemblies die dan op een specifieke manier (tijdelijk) met elkaar verbonden worden. Het verwerken van informatie die weergegeven wordt in de zin, is dan inderdaad een proces van het selectief activeren van cell assemblies (Van der Velde & de Kamps, 2006)15.

De cell assembly van Hebb kan vergeleken worden met een grounded symbool zoals beschreven door Harnad (1991). Eigenlijk is het meer dan dat. Het laat zien waaruit grounding zou kunnen bestaan: een aangeleerde netwerkstructuur die een specifieke verbinding vormt tussen perceptie en actie. Je zou daar een ‘symbool’ aan kunnen toevoegen in de vorm van een naam, zoals dat gebeurt in taal. De woorden die wij gebruiken in taal, zijn dan geleerde symbolen (klanken) die door ervaring (bijvoorbeeld met de Hebb-regel) verbonden worden met een cell assembly. Daarmee zijn onze woorden in taal gegrond in perceptie en actie. Het concept ‘hond’ bijvoorbeeld, is een ‘grounded’ concept. De activatie van het concept in het brein bestaat namelijk uit de (gedeeltelijke) activatie van de cell assembly die ontstaan is uit onze ervaringen met honden.

Wellicht hoeven niet alle woorden in een taal op die manier hun betekenis te krijgen. Wij kunnen ook woorden (concepten) leren door relaties te leggen met andere concepten. Deze woorden leren wij op een manier zoals Watson ook woorden kan leren. Maar aan de basis van dat proces staan de concepten die grounded zijn.

Carr en Harnad (2011)5 beargumenteren dat ook de woorden die wij leren op de manier van Watson kunnen veranderen in concepten die direct grounded zijn. Als voorbeeld geven ze het verkrijgen van kennis over wijn. Een beginnende wijnkenner zal begrippen over smaak en dergelijke leren uit lessen of handleidingen. Maar door veel ervaring krijgen die begrippen dan een betekenis die direct gebaseerd is op die ervaring. De begrippen kunnen daarmee, subtiel, veranderen. Dergelijke, op ervaring gebaseerde conceptveranderingen zullen zich ook voordoen bij andere vormen van kennisontwikkeling die gepaard gaan met het opdoen van veel ervaring (denk aan kennis over muziek of inzicht in een bepaalde sport).

Watson en grounding

Maar hoe zit dat bij Watson? Heeft Watson een basisset van grounded concepten? En gaan bij Watson ook concepten veranderen als hij meer ervaring heeft? Dan zal Watson ervaringen moeten opdoen die de verbindingen kunnen vormen tussen perceptie en gedrag. Dus moet Watson beschikken over sensoren en actuatoren. Anders gezegd, Watson moet een robot worden – of moet daarmee worden verbonden.

Maar dan nog is het de vraag of de talige manier van informatie verwerken die Watson gebruikt wel geschikt is voor alle vormen van ervaring. De cell assemblies van Hebb laten zich niet (volledig) in een talige manier beschrijven (Van der Velde, 2015)16. Ze belichamen juist ook veel procedurele vormen van kennis. De AI heeft een tijd geprobeerd om procedurele vormen van kennis op een talige manier te modelleren. Maar dit bleek vaak omslachtig en storingsgevoelig.

Een mooi voorbeeld daarvan wordt gegeven in de film Robocop van Paul Verhoeven. Robocop is een agent die na zijn ‘overlijden’ wordt omgevormd tot een hybride robot. Hij heeft duidelijk robotkenmerken en -vermogens maar bezit ook nog een eigen biologisch lichaam en vormen van biologische cognitie. Op een gegeven moment komt Robocop in gevecht met een klassieke robot waarvan de politie al een tijd gebruik maakt – een waar monster. Het begin van het gevecht verloopt dan ook slecht voor Robocop. Hij krijgt alle hoeken van de kamer te zien. Op een gegeven moment vlucht Robocop en neemt de trap naar beneden. De robot achtervolgt hem maar blijft bovenaan de trap staan. Je ziet hem haast ‘denken’ of beter gezegd ‘uitrekenen’: hoe scherp is de hoek naar beneden; hoe ver moet ik het rechterbeen naar voren doen? Omdat Robocop is gevlucht, neemt de robot het besluit hem te volgen en begint aan de afdaling. Maar na een paar treden verliest hij zijn evenwicht en valt met donderend geraas naar beneden. De boodschap is duidelijk. Handelingen zoals snel een trap aflopen zijn niet zo gemakkelijk te berekenen. Alleen al niet omdat daarbij zeer veel variabelen een rol spelen die telkens weer anders zijn. Hier schiet de talige aanpak van cognitie tekort.

Brooks (1991)4 liet dit ook zien aan de hand van de robots die hij ontwierp. Deze robots gebruikten hun eigen mechanisch systeem bij het controleren van hun beweging in plaats van een complex programma dat allerlei berekeningen uitvoert. De robots van Brooks bewegen door een mechanische aandrijving. Als ze een obstakel tegenkomen, dan passen ze hun beweging aan door de mechanische feedback die door het obstakel wordt veroorzaakt. De beweging wordt dus niet gecontroleerd door een berekening, maar door een dynamische interactie met de omgeving (Brooks, 1991). Dit heeft geleid tot het idee dat cognitie in het geheel ontstaat uit dynamische processen, en niet uit talige vormen van informatieverwerking (Van Gelder & Port, 1995)14.

Programmeren of leren

De overgang van het berekenen van bewegingen naar bewegingen die volgen uit een dynamische interactie met de omgeving staat model voor een meer algemene verandering in het inzicht over hoe cognitie ontstaat. Een voorbeeld hiervan is de visie op cognitie van Barsalou (1999)1. In deze visie bestaat cognitie niet uit talige vormen van kennis maar uit aangeleerde patronen van perceptie en actie. Ook taal en redeneren komen voort uit aangeleerde patronen van perceptie en actie. Voorbeelden zijn de manieren waarop metaforen ons denken bepalen (Lakoff, 1987)11 en hoe ‘constructies’ ons taalvermogen bepalen (Goldberg, 2006)7. Deze constructies zijn in het geheugen opgeslagen patronen van woorden of woordkenmerken die vaak in de gebruikte taal voorkomen en zo ook worden aangeleerd. Ons taalvermogen komt dan voort uit het toepassen en combineren van deze constructies en niet uit het uitvoeren van al dan niet aangeboren taalregels.

Deze ontwikkelingen laten dus een verschuiving zien van een meer taal-achtige beschrijving van cognitie naar een meer patroon-achtige beschrijving van cognitie (Barsalou et al., 2003)2. Voor AI en dus ook robotica betekent dit een verschuiving van een programmeerbenadering van cognitie naar een leerbenadering van cognitie. Talige vormen van cognitie kunnen worden geprogrammeerd, zoals Watson goed laat zien. Daarentegen moeten patroonachtige vormen van cognitie meer worden aangeleerd.

Voor de goede orde is het belangrijk om te begrijpen dat dit verschil niet zwart-wit is. Ook Watson leert van wat hij doet en wordt zo ook duidelijk beter. En om te leren moet een leerprogramma worden geprogrammeerd. Toch is dit verschil belangrijk. Vooral als het gaat om het aanleren van procedurele vormen van cognitie op basis van de interactie tussen perceptie en actie. Procedureel leren is belangrijk voor het aanleren van beweging, maar grounded cognitie maakt duidelijk dat het ook belangrijk is voor het aanleren van concepten over de wereld en daarmee ook voor de talige vormen van cognitie.

Robots

Wat is hiervan nu het gevolg voor robotica? Dit hangt af waarvoor een robot wordt gebruikt. Robots in de industrie zijn vaak gespecialiseerd in het betrouwbaar uitvoeren van zeer specifieke handelingen in een hoog tempo. Hier hangt het van geval tot geval af of dit gedrag tot stand komt door leren of programmeren.

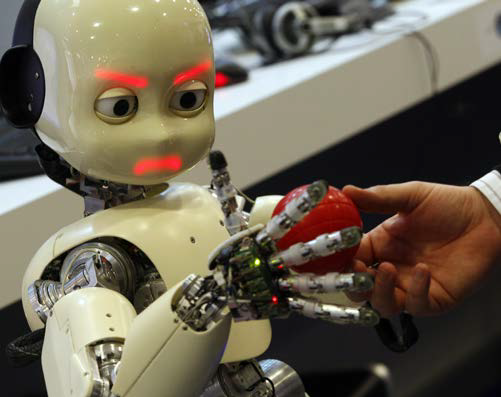

Maar bij robots die geacht worden met mensen om te kunnen gaan, is er duidelijk een verschuiving waarneembaar van programmeren naar leren. Een mooi voorbeeld daarvan is de iCub-robot (zie figuur). Deze robot is tien jaar geleden ontwikkeld in een Europees onderzoeksproject (icub.org). De ontwikkeling van de robot is sindsdien doorgegaan. Binnenkort zal de Universiteit Twente, als eerste in Nederland, over de nieuwste versie van deze robot beschikken.

De letters Cub in de naam staan voor Cognitive universal body. Deze naam komt voort uit de doelstelling van de iCub. De robot moet cognitief gedrag gaan vertonen op basis van de manier waarop hij omgaat met en leert van zijn omgeving. De iCub gebruikt daarvoor zijn lichaam en door de leerprogramma’s die hij heeft (of die worden ontwikkeld) leert hij niet alleen zijn omgeving kennen, maar ook zijn eigen gedragsmogelijkheden.

De iCub in figuur 1 leert onderscheid te maken tussen een blauwe en een groene bal. Daarmee kan hij zijn aandacht richten op een van de twee en die dan proberen te pakken. Daarvoor moet hij zijn lichaam, arm en hand zo aansturen dat de bal binnen bereik komt. Bij het leren van deze aansturing leert de robot ook wat ‘ruimte’ is en welke relaties er in die ruimte kunnen bestaan. De blauwe bal ligt bijvoorbeeld naast de groene, maar die had er ook achter kunnen liggen. Stel dat de iCub eerst de groene bal heeft gepakt en vervolgens de blauwe bal naast of achter de groene bal gaat pakken. Het bewegingsverloop is in beide gevallen anders. Door dit verschil kan hij leren wat ‘naast’ of ‘achter’ betekent. Deze kennis kan de iCub dan later in andere situaties toepassen – bijvoorbeeld als hij de instructie krijgt een willekeurig object te pakken en dat te plaatsen achter (of naast) een ander willekeurig object of aangewezen positie.

Deze manier van werken past bij grounded cognitie. De betekenis van concepten zoals achter of naast worden niet in-geprogrammeerd, maar aangeleerd. Daardoor wordt de betekenis van deze concepten bepaald door het gedrag van de robot, en verankerd in de perceptie en actiemogelijkheden van de robot.

Een ander voorbeeld daarvan ontstaat bij het oppakken van de blauwe bal. Op dat moment leert de robot of de bal zwaar of licht is en of het oppervlak hard of zacht is. Ook dit zijn begrippen (concepten) die nauw verankerd zijn met directe ervaringen. Naarmate de robot meer van dergelijke ervaringen opdoet, ontstaat ook een meer abstract begrip van hard en zacht of licht en zwaar. Uiteindelijk zou hij dan in staat moeten zijn om deze begrippen ook in een talige vorm te kunnen gebruiken. Daarvoor moet hij dan wel een taalvermogen ontwikkelen dat mede gebaseerd is op zijn gedrag en leervermogen.

Vrijheidsgraden van de iCub

Omdat de lichamelijke acties belangrijk zijn voor het leren van de robot, is het zinnig wat meer te kijken naar de fysieke mogelijkheden van de iCub. De robot is 104 centimeter hoog en 22 kilo zwaar. Deze maten zijn niet geheel toevallig maar komen voort uit het idee dat de robot gedrag ontwikkelt en begrip over zijn omgeving aanleert zoals een jong kind dat zou doen. Daarnaast heeft zijn lichaam 53 zogeheten vrijheidsgraden of DOF’s (degrees of freedom). Bovendien heeft het hoofd nog eens zes DOF’s.

Een DOF is een belangrijk begrip in de robotica. Zo’n vrijheidsgraad geeft aan welke verschillende bewegingen een robot kan uitvoeren. Elke DOF staat voor een beweging van een bepaald onderdeel van de robot in een bepaalde richting (dimensie). In feite staat een DOF voor een scharnier. Voorbeelden zijn de bewegingen die een robot kan uitvoeren met zijn armen, zoals op en neer ten opzichte van de schouder, of de onderarm omhoog of omlaag rond de elleboog. Maar ook de vingers hebben DOF’s. Deze worden bepaald door de beweging van de vinger ten opzichte van de hand, en de beweging van een vingerkootje ten opzichte van een ander kootje. In de handelingen van de robot moeten alle DOF’s worden gereguleerd – bepaald geen eenvoudige opgave.

De bewegingen zelf worden uitgevoerd met elektromotoren. Een belangrijk punt daarbij is de wijze waarop de kracht van een motor wordt gereguleerd. De iCub heeft krachtcontrole. Daarmee kan hij de kracht van een motor reguleren aan de hand van de weerstand die hij ontmoet. Een robot is een mechanisch object en het uitvoeren van beweging kan gevaarlijk zijn bij het contact met mensen als de robot niet in staat zou zijn die kracht bij contact te verminderen. Om de wereld om hem heen te kunnen waarnemen, beschikt de iCub over camera’s en microfoons. Maar hij heeft ook sensoren die de mate van een beweging registreren, zodat hij de beweging precies kan leren uitvoeren. Ook heeft de iCub 108 tast-sensoren of taxels voor de vingertoppen en handpalmen en heeft hij een ‘huid’ die aanraking registreert.

Al deze sensoren en actuatoren maken dat de iCub veel informatie kan registeren en complexe handelingen kan uitvoeren. Dat heeft hij uiteraard nodig om cognitief belangrijke begrippen over zijn omgeving en zijn eigen handelen te kunnen leren en gebruiken. Hopelijk verduidelijkt deze opsomming van de technische gegevens van de iCub dat een humanoïde robot met cognitieve vermogens een zeer complex en in mechanisch opzicht ook kwetsbaar systeem is.

Doel van robots als de iCub

Waarom zouden we eigenlijk robots als de iCub willen ontwikkelen? Daar zijn een aantal redenen voor aan te geven. Ten eerste: om meer over onszelf te leren. Wij ontwikkelen onszelf ook door de interacties die we aangaan met de omgeving. Die gedragsontwikkeling gaat gepaard met een cognitieve ontwikkeling, omdat we zo ook onze omgeving en onszelf beter leren kennen, in letterlijke zin. Met robots als de iCub kunnen we gericht gaan onderzoeken welke factoren hierbij van belang zijn.

Neem het aanleren van ruimtelijke concepten als ‘voor’, ‘achter’ of ‘naast’. De robot zou de betekenis van deze concepten kunnen leren door het uitvoeren van een reeks handelingen waarbij een object ‘voor’, ‘achter’ of ‘naast’ een ander object (of positie) moet worden geplaatst. Door het uitvoeren van deze handelingen kan hij dan een relatie leren tussen de (visuele) positie van de objecten en de uitgevoerde bewegingen die nodig zijn om een voorwerp ‘voor’, ‘achter’ of ‘naast’ een ander object te plaatsen. De vraag is dan of hij de betekenis van deze ruimtelijke begrippen zal koppelen aan de onderliggende handelingen. Kan hij dan bijvoorbeeld in een andere situatie de goede positie vinden als hij de opdracht krijgt om iets ‘voor’, ‘achter’ of ‘naast’ een ander object aan te wijzen of te pakken?

Uiteraard is de robot geen mens en heeft hij niet een biologisch lichaam dat steeds in ontwikkeling is. Maar we hebben wel directe toegang tot de manier waarop de robot leert en tot wat hij leert. We kunnen immers in detail in zijn ‘brein’ kijken en we kunnen steeds opnieuw experimenten uitvoeren en de effecten daarvan in detail onderzoeken. We zouden dus in staat kunnen zijn om te begrijpen hoe cognitieve vermogens ontstaan bij een systeem of organisme dat die vermogens ontwikkelt in een voortdurende interactie met de omgeving, ook al zijn lichaam en brein in mechanisch opzicht anders dan bij de mens.

Een achterliggende veronderstelling hierbij is dat het aanleren van cognitieve vermogens wellicht bepaalde ‘invarianten’ bevat. Dat wil zeggen dat hierbij aspecten een rol spelen die voorkomen bij elk systeem of organisme dat op deze wijze over en van zijn omgeving leert. Neem als voorbeeld weer het aanleren van ruimtelijke concepten als ‘voor’, ‘achter’ of ‘naast’. De bewegingen die de robot zou kunnen uitvoeren bij het aanleren van deze concepten, bestaan uit de bewegingen van zijn lichaam, armen en handen. De mechaniek van deze bewegingen is anders dan de bewegingen die mensen met hun biologische lichaam maken. Toch zijn er overeenkomsten tussen de handelingen die een robot en een mens uitvoeren als ze bijvoorbeeld een voorwerp ‘achter’ een referentiepunt met hun arm en hand moeten pakken of aanraken. In beide gevallen moeten ze zich ‘verder’ strekken dan wanneer ze een voorwerp ‘voor’ het referentiepunt moeten aanraken of pakken. Dit verschil tussen ‘achter’ en ‘voor’ is onafhankelijk van de mechaniek van de uitgevoerde beweging. Het verschil tussen ‘voor’ en ‘achter’ is daarmee overdraagbaar van het ene (bio)mechanische systeem naar het andere en is in die zin ‘invariant’.

Een tweede reden is dat we dit onderzoek kunnen gebruiken om robots te ontwikkelen die ons kunnen helpen. Dit zijn de zogeheten servicerobots of sociale robots. Denk aan robots die in gevaarlijke omstandigheden handelend kunnen optreden waar dat voor mensen niet mogelijk of wenselijk is, zoals bij het opruimen van explosieven. Of denk aan robots die zwaar en moeilijk werk kunnen overnemen waar goed ontwikkelde cognitieve vermogens voor nodig zijn. We kunnen ook denken aan robots die mensen kunnen ondersteunen bij bepaalde taken. Een voorbeeld is een robot die mensen met slecht zicht zou kunnen begeleiden op straat of in huis. Dit hoeft natuurlijk niet een robot te zijn zoals de iCub. Het zou ook, in voorkomende gevallen, een robotaansturing kunnen zijn van een rolstoel, eventueel aangevuld met bepaalde actuatoren om objecten aan te pakken of neer te zetten.

Gezien de voorspellingen over de bevolkingsopbouw, met name de toename van het aantal ouderen ten opzichte van het aantal jongeren, kunnen dergelijke robotsystemen gaten opvullen in de ondersteuning van mensen die anders niet of moeilijk zijn in te vullen. Dat wil niet zeggen dat zij het contact tussen mensen (moeten) vervangen. Wellicht integendeel; ze zouden juist de ruimte kunnen scheppen om dat contact nog te laten plaatsvinden.

Afronding

De iCub is een humanoïde robot omdat zijn lichaam is gemodelleerd naar de mens. Het zijn juist vaak deze robots die vrees oproepen. Maar deze vrees is gebaseerd op het direct extrapoleren van een ontwikkeling die een aantal jaren vooruitgang heeft laten zien. Uitgaande van het niveau van de eerste computers in de jaren vijftig van de vorige eeuw is Watson een enorme vooruitgang. Wellicht dat deze vooruitgang zich lineair zal voortzetten of zelfs zal versnellen (Bostrom, 2014). Hetzelfde geldt voor robots als de iCub.

Diezelfde ontwikkeling laat ook zien hoe moeilijk het is om menselijke cognitie en gedrag ook maar bij benadering in een robotsysteem te modelleren. De ontwikkeling van robots is nog ver verwijderd van de vrijheid waarmee wij bewegen en handelen en het bijna speelse gemak waarmee wij leren. Alleen al het feit dat het brein opereert met een vermogen van slechts twintig Watt staat ver af van het benodigde vermogen om een robot te laten bewegen en denken. Dit geldt evenzeer voor AI-systemen zoals Watson.

Uiteraard zijn er ontwikkelingen mogelijk in de AI die zorgelijk kunnen zijn. Dit geldt nu al bij het gebruik van grootschalige en gedistribueerde computersystemen die veel informatie over ons kunnen verzamelen en eventueel kunnen (laten) gebruiken. Andere voorbeelden zijn drones of ander wapentuig dat geprogrammeerd zou kunnen worden om zelf beslissingen te nemen.

Maar bij de ontwikkeling van een servicerobot die gemodelleerd zou zijn aan de iCub is het nu nog vooral eerst zaak dat hij leert een kopje koffie in te schenken zonder daarbij teveel te morsen.